From Human Bias to AI Bias

편견이 없는 AI가 더 나은 AI일까?

인간은 수많은 편견과 모순으로 가득한 존재입니다. 이는 인간을 모방하여 정보를 습득하고, 학습하는 인공지능이 인간의 편견 또한 확대하고 재생산할 수 있다는 의미이기도 합니다. 최근 한 기업의 인공지능 채용 프로그램이 성별에 따른 차별적 결과를 보여 사회적으로 큰 논란이 되기도 하였는데요. 기술의 발전만큼이나 그에 따른 인공지능 설계와 이용의 중요성에 대한 목소리도 높아져 가고 있습니다. 그렇다면 기술적으로 편견을 통제할 수 있을까요? 편견이 완전히 제거된 인공지능을 더욱 윤리적인 인공지능이라고 할 수 있을까요?

[AI FRAMEWORK]는 인공지능과 인류의 미래를 고민하는 세계적인 석학들의 눈을 통해 ‘AI를 바라보는 새로운 관점’을 제시하는 엔씨의 새로운 콘텐츠 시리즈입니다. 엔씨의 AI Center 설립을 주도하며 첨단 기술의 윤리적 문제를 탐구해 온 윤송이 CSO가 공학, 정치학, 철학 등 각 분야의 리더들을 만나 서로의 생각과 관점을 나눕니다.

앨리슨 시몬스 교수님에 이어 대화를 나눌 인물은 미국의 철학자이자 MIT의 언어 및 철학과 학과장을 역임한 알렉스 번 교수입니다. 이번 편에서는 인공지능에게 어떤 윤리적 기준을 적용해야 할지, 그리고 더 나아가 윤리적인 인공지능을 만들기 위해서 편견을 완전히 제거하는 것이 해답이 될 수 있을지에 대해서도 이야기를 나눠보겠습니다.

AI [Society] Framework

2. From Human Bias to AI Bias

편견이 없는 AI가 더 나은 AI일까?

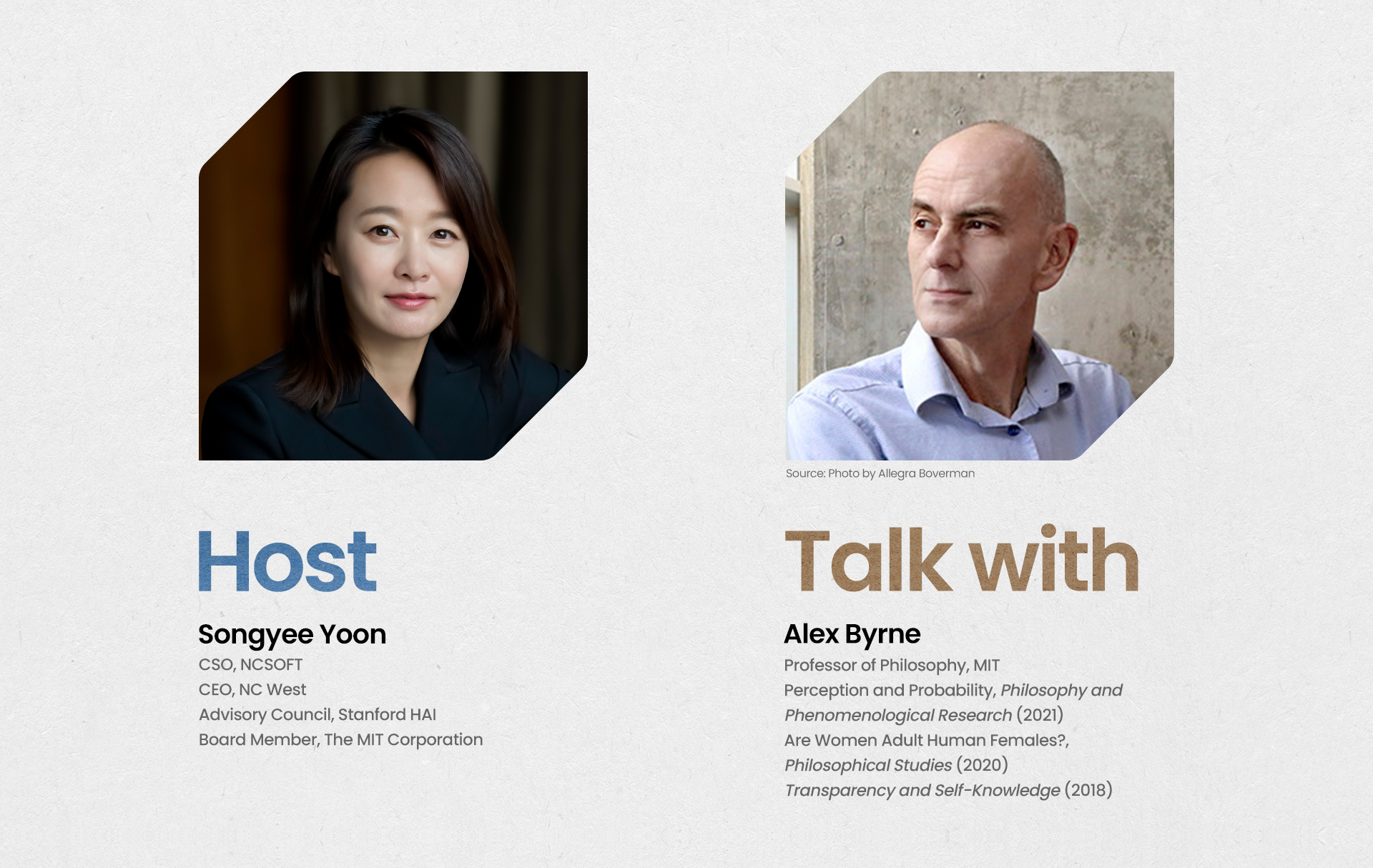

Songyee Yoon

엔씨소프트의 사장(최고전략책임, CSO)이자 북미 법인(NC West) 최고 경영자로 엔씨의 글로벌 사업 전략을 총괄하고 있다. 엔씨의 AI Center 설립을 주도해 AI와 NLP에 관한 다양한 연구 개발 성과를 기업 경영에 접목하고 있다. 특히 AI가 미치는 사회적 영향과 AI 윤리를 지속적으로 고민하며, 현재 미국 스탠퍼드 인간중심 AI 연구소(Human-Centered AI Institute, HAI) 자문 위원과 메사추세츠 공과대학(MIT) 이사회 이사로 활동 중이다.

Alex Byrne

미국 철학자이자 MIT 대학에서 언어 및 철학과 학과장을 역임하고 현재 철학 교수로 재직중이다. 오랜 시간 언어학과 철학을 연구하며 심리철학을 바탕으로 자기 인식과 인식론에 관심을 가지고 활발한 연구 및 저술 작업을 하고 있다. 2018년 “Transparency and Self-Knowledge”, 2021년에는 “Perception and Probability”를 집필했다.

Who Determines Fairness

‘공정하다’라는 것

윤송이 공정성과 같은 간단한 개념의 경우에도 어떤 그룹에서는 공정하지만 다른 그룹에는 공정하지 않은 무엇인가가 존재할 수 있습니다. 누구의 공정이 가장 중요한지는 누가 결정할까요? 우리는 그런 문제에 어떻게 접근해야 할까요?

알렉스 번 객관적인 옳고 그름은 존재하지 않는다는 극단적인 형태의 사고가 있습니다. 모든 것은 상대적이죠. 나의 가치에서 비춰 보았을 때 옳은 일이 상대의 가치에 비춰 보면 옳지 않은 선택일 수 있다는 것입니다. 그리고 중립적으로 결론을 내릴 결정권자는 없습니다. 알렉스의 가치는 옳고 송이의 가치는 틀린 것이라는 식으로 말이죠. 만약 그런 식으로 생각한다면 어떤 의견도 낼 수 없게 된다는 말입니다. 무의미해지는 것입니다. 그리고 그것은 그저 거대한 권력 싸움이 되어 버리고 맙니다. 누군가가 힘으로 이길 것인가 아니며 논쟁으로 이길 것인가 사이의 문제가 되거나 누가 결과적으로 이기느냐의 문제가 되겠죠. 하지만 그런 상황은 잠시 미뤄 두고 우리가 여기서 논의하고, 논쟁하고, 발견할 무언가가 있다는 것에 합의한 이후에도 분명 쉬운 해결책은 없을 것입니다. 책장에서 책 하나를 꺼내서 “그런 윤리적 문제에 대한 해답은 모두 여기에 있어요.” 하고 말할 수는 없다는 것이죠. 하지만 적어도 우리가 이야기해 보고 논쟁해 볼 것들과 잠재적으로 발견할 무언가는 있습니다.

From Fantasy to Reality

인공지능에게 ‘윤리’를 요구할 수 있을까

윤송이 한편으로는 인공지능 솔루션(AI solutions)에 대해 항상 이야기하는 문제 중 하나가 바로 인공지능이 모든 면에서 일부 편견을 지닌 실제 인간의 데이터를 기반으로 하고, 그렇기 때문에 편견을 확대하고 재생산한다는 것인데요. 우리 인간들이 편견에서 자유롭지 못한 상태에서 인공지능에게 더 높은 윤리 기준을 기대할 수 있을까요?

알렉스 번 맞아요. 물론 이것은 문제이지요. 많은 사람들이 다양한 종류의 인공지능에 대한 글을 썼습니다. 예를 들어, 안면 인식을 하거나 이력서를 검토하는 인공지능에 대해서요. 제 생각에 여기선 기술적인 문제와 철학적인 문제를 구분하는 게 도움이 될 것 같아요.

그러니까 기술적인 문제라는 것은 예를 들어, 어떤 안면 인식 소프트웨어가 특정 인종이나 성별을 잘 인식하지 못한다면 우리가 이 소프트웨어를 선한 목적으로 사용하느냐, 악한 목적으로 사용하느냐는 문제가 되지 않는다는 것입니다. 특정 집단의 얼굴을 제대로 인식하지 못하는 안면 인식 소프트웨어는 아무도 원하지 않을 테니 이 소프트웨어를 개선하는 것이 문제겠죠.

하지만 공정성(fairness)이라는 개념을 다르게 조작(operationalization)을 한다고 했을 때 이는 철학적인 차원의 문제가 됩니다. 공정한 결과에 대한 개념을 조작화하는 다양한 산술적인 방법(mathematical ways)이 있음이 드러났고, 사실 그 방법들은 모두 호환되지는 않습니다. 하나를 선택하면 다른 하나를 포기해야 합니다. 다른 한 쪽을 더 선호하기 때문에 공정성을 조작하는 하나를 포기해야 하고, 그때 어떤 선택을 할 것인지 결정해야 하는거죠. 이건 전적으로 기술적인 문제가 아니고, 윤리적이거나 철학적인 문제라고 볼 수 있습니다. 저는 안면 인식 소프트웨어와 관련된 많은 이슈, MIT의 젠더 쉐이드 프로젝트(Gender Shades Project) 등은 대부분 기술적인 문제와 관련되어 있다고 생각합니다. 이런 문제는 상대적으로 쉽습니다.

*각주1) 젠더 쉐이드 프로젝트(Gender Shades Project): MIT 미디어랩의 조이 부오라뮈니(Joy Buolamwini) 연구원이 기술 알고리즘이 가지고 있는 편견을 찾아내고자 진행한 프로젝트로, 얼굴 인식 프로그램이 성별 및 인종에 따라 분류 정확도에 차이를 보이는 것으로 나타났다.

알렉스 번 제가 말씀드리려는 건 기술적인 문제를 해결하는 것도 매우 어렵지만 아까 송이 님께서 말씀하신 사회적 합의에 대한 문제에 대해서는 아무도 이의를 제기하지 않는 사람들 간의 합의가 존재한다는 겁니다. 하지만 이런 사회적 합의가 존재하지 않는, 훨씬 더 어려운 문제들이 존재합니다.

윤송이 저는 엔지니어들이나 심지어 테크 기업의 임원들조차도 제품을 개발하면서 윤리적이거나 철학적인 기준을 생각하는 데에 익숙하지 않다고 생각해요. 알다시피 늘 성과를 위한 최적화에만 집중하고 있죠.

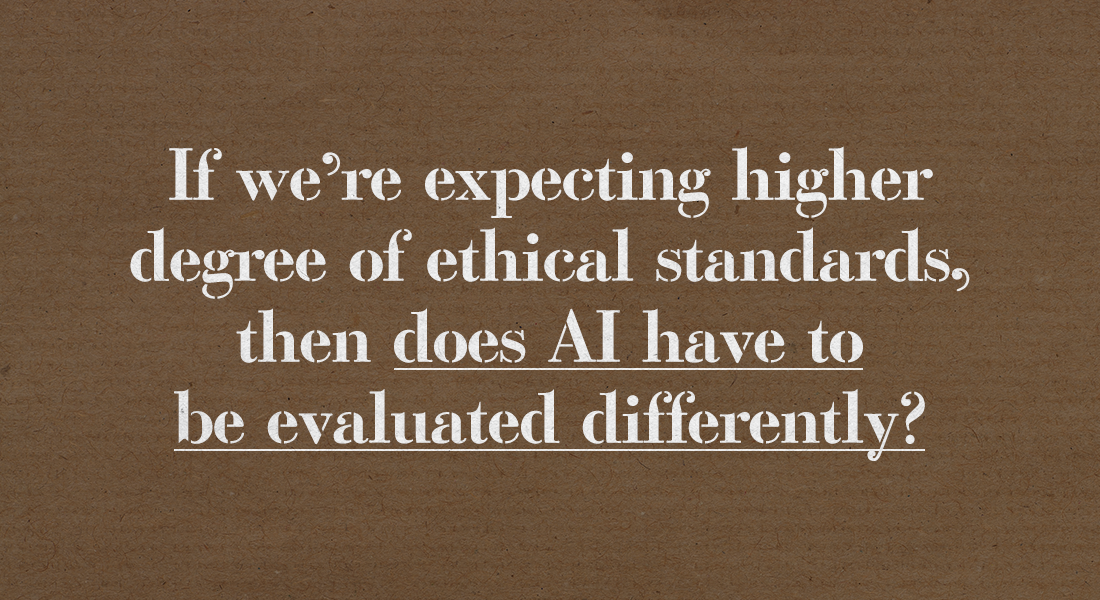

하지만 우리가 특정 환경에서 특정 방식으로, 특정한 결정을 내리는 기계를 생산한다고 가정해 본다면 예상치 못한 환경이나 상황에서 결정할 수 있도록 일종의 기준을 갖추는 것은 매우 중요해집니다. 이런 경우, 로봇이나 인공지능이 사람이 가진 윤리적 기준보다 높은 기준을 지녀야 할지, 아니면 온갖 종류의 단점과 편견 등으로 얼룩진 대다수의 인간처럼 행동해야 할지 문제가 제기된다고 생각합니다. 그리고 이 문제는 인공지능에 있어서 ‘과연 더 나은 성과란 무엇인가’의 문제로 되돌아갑니다. 우리는 지금껏 굉장히 선형적인 기준(linear standard)으로 인공지능의 성과를 측정해 왔는데요, 만약 우리가 인공지능에게 더 높은 수준의 윤리 기준을 기대한다면 인공지능을 평가하는 방식도 바뀌어야 할까요?

알렉스 번 인공지능이 인간의 성과를 뛰어넘을 수 있는 몇 가지를 생각해 볼 수 있습니다. 인공지능은 인간의 일반적인 능력(competence)은 뛰어넘을 수 없을지 몰라도, 윤리적인 결정에 있어서는 인간의 판단 능력(performance)을 넘어설 수 있습니다. 하나의 예를 들어 볼게요. 제가 어떤 편견을 가지고 여성과 남성의 이력서를 평가한다고 해 보죠. 제가 이력서를 평가할 때 여성보다 남성을 좋게 보는 경향이 있다고 가정하면, 이론적으로는 이력서 평가에 있어 저와 동일한 의사 결정 과정을 따르되 성별에 대한 편견이 없도록 인공지능을 프로그래밍할 수 있겠죠. 그렇게 되면 이 인공지능은 저와 동일하지만 남성에 대한 선호를 뺀 제 자신이 되는 것입니다. 실제의 저보다 약간 더 나은 버전의 제가 되는 거죠. 이러한 방식으로 인공지능은 인간보다 더 나은 형태가 될 수 있는 것이죠. 인공지능은 질적으로 인간의 윤리적 사고와 매우 다른 사고를 할 가능성이 큽니다. 우리가 직감적으로 절대 옮지 않다고 여기는 선택이더라도 인공지능은 선택할 수 있는 거죠.

알렉스 번 하지만 사실상 인공지능은 인간보다 윤리에 대해 더욱 깊이 이해하고, 윤리 규칙들이 어떻게 작동하고 서로 균형을 유지하는지에 대해 인간보다 더 깊은 지식을 가지고 있습니다. 인간은 할 수 없는 수학 계산을 컴퓨터가 계산해 낸 것과 비슷한 상황인 거죠. 인간은 그저 얼마의 얼마 제곱이 얼마라는, 내가 생각할 수도 없는 정답을 컴퓨터가 찾아낼 때 놀라워할 뿐이었습니다. 그래서 우리는 윤리적인 영역에서도 인공지능이 잘 해낼 거라는 환상을 갖게 되죠. 우리는 그저 인공지능이 찾아낸 해결책에 감탄하며 그 해결책대로 진행하자고 생각할 겁니다. 누가 이런 것을 상상이나 했을까요?

저는 도덕이 이런 상황을 원하리라고는 상상도 못 했어요. 이건 너무 직관적이지 않아요지만 우리는 인공지능을 신뢰해야 합니다. 어쩌면 정말 환상일 수도 있겠지만 상상해 볼 만한 가치는 있습니다. 원칙적으로 이런 상황이 일어날 수 있는지에 대해 생각해 보는 것은 흥미롭습니다. 윤리의 근본적인 진실은 평범한 사람들이 접근하기 너무 어려워서 소수의 엄청난 인공지능만이 그러한 진실을 진정으로 이해할 수 있는 걸까요?

Bias in AI

AI와 편견

윤송이 네, 우리 인간은 편견과 단점들로 가득 차 있습니다. 동시에, 그 편견과 단점은 우리의 진화와 경험이 반영된 것입니다. 혹은 우리가 특정한 환경에서 수년간 살아오며 습득한 지름길일 수도 있죠. 그리고 저도 평등이 굉장히 중요하다는 데 동의합니다.

질문을 위한 질문을 해 보자면, 우리가 어떻게 편견의 완전한 부재가 더 나은 전략이라거나, 옳은 것이라고 확신할 수 있을까요? 우리 사회가 어떤 이유로 인해 그런 방향으로 진화해 온 것이라면요? 절대적인 의미에서 진정으로 옳고 그른 것이 무엇인지 알 수 없다면, 모든 것은 상대적이게 됩니다.

그리고 모든 것이 상대적이라면 우리는 어떻게 편견의 완전한 부재가 항상 옳고, 더 나으며, 더 우월한 윤리적 가치라고 말할 수 있을까요? 반대로, 사회에 존재하는 모든 추악한 편견을 재생산하고 확대하는 게 대안이 될 수 있겠죠. 그래서 우리는 또 다른 딜레마에 빠지게 된다고 생각합니다.

알렉스 번 맞아요. 제 생각엔 그 문제가 바로 편견이 가진 의미인 것 같아요. 어떤 의미로는 편견을 가진 것 자체가 나쁜 건 아닙니다. 예를 들어, 이력서에 있어 좋은 학점이나 인상적인 경력 등을 선호하는 편견을 가진다면 그건 좋은 거죠. 하지만 특정 성별이나 인종의 이력서를 선호한다면 그건 나쁜 거죠.

그러니까, 중립적인 의미로 편견을 이해한다면, 모든 좋은 판단에는 모종의 편견이 개입되는 것이고 그건 부끄러워할 일이 아닙니다. 그리고 대체로 일반적인 의미로의 편견은 상관없는 요소들을 고려한다는 것(take some irrelevant factor into account)이고, 우리가 이러한 상관없는 요소들을 가려낼 수만 있다면, 제 생각에는 인공지능 자체가 이런 무관한 요소들을 배제(ignoring irrelevant factors)하고 편견 문제를 해결하는 데 적합할 것 같습니다. 일부 인간들이 지적을 받는 경우에도 판단에 무관한 요소들을 무시하기 어려워하는 것과는 다르게요.

*Any endorsements, views, opinions, and appearances shared by the interviewee are made solely in his/her/their personal capacity; MIT does not endorse this organization or its products or services.

Facebook

Facebook  KakaoTalk

KakaoTalk  LinkedIn

LinkedIn  Email

Email  Copy URL

Copy URL